隨著智能交通領(lǐng)域的快速發(fā)展,端到端技術(shù)已成為輔助駕駛進階的核心方向。本篇推文系統(tǒng)梳理了輔助駕駛的發(fā)展歷程,從 1.0 時代的 2D 感知,到 2.0 時代的 BEV 感知,再到如今 3.0 時代的端到端技術(shù),清晰呈現(xiàn)了不同階段的技術(shù)特征與演進邏輯。本篇推文深入解析了支撐端到端輔助駕駛的大模型基礎(chǔ),包括大語言模型、視頻生成模型及仿真渲染技術(shù)的核心原理與應(yīng)用場景,并進一步闡述了端到端輔助駕駛的網(wǎng)絡(luò)架構(gòu)、技術(shù)支撐及訓練范式,為理解這一前沿技術(shù)提供了全面且深入的視角。

一、輔助駕駛發(fā)展歷程(一)端到端的定義與演進邏輯

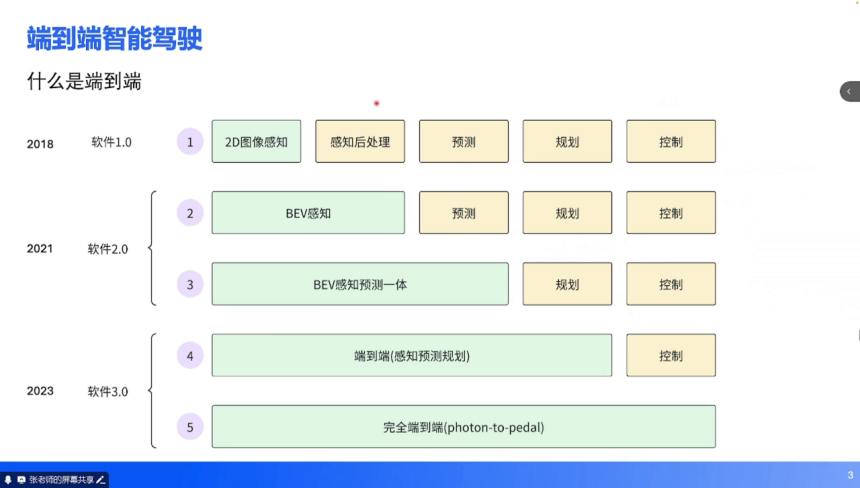

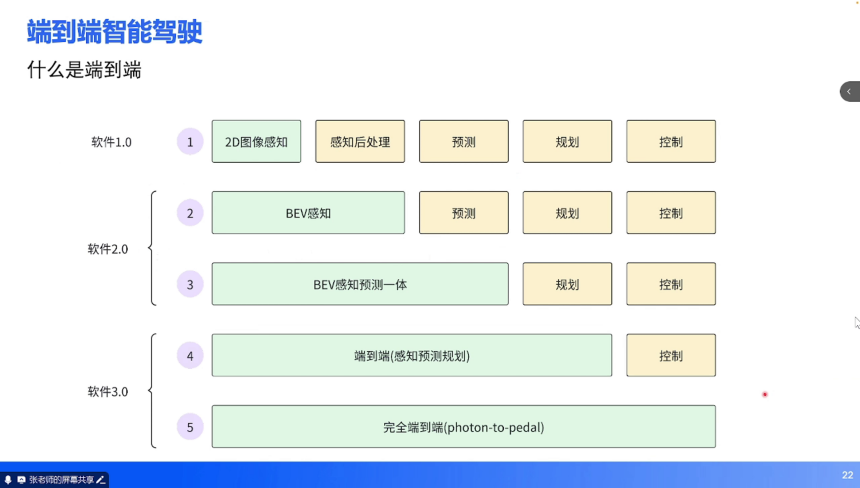

輔助駕駛的發(fā)展歷程可視為技術(shù)范式不斷迭代的過程,而端到端技術(shù)是這一演進的最新階段。從行業(yè)實踐來看,輔助駕駛的發(fā)展可劃分為五個階段,對應(yīng)軟件 1.0 到軟件 3.0 的技術(shù)躍遷:

1. 軟件 1.0 階段(2018 年左右):核心特征是 2D 圖像感知與傳統(tǒng)算法結(jié)合。神經(jīng)網(wǎng)絡(luò)僅負責 2D 圖像的檢測(如車輛 2D 包圍框、車道線)與分割(如可行駛區(qū)域),后續(xù)的感知后處理、、規(guī)劃、控制均依賴 C++ 等傳統(tǒng)邏輯代碼實現(xiàn)。

2. 軟件 2.0 階段(2021 年左右):BEV(Bird's Eye View,鳥瞰圖)感知技術(shù)崛起。神經(jīng)網(wǎng)絡(luò)實現(xiàn)了 2D 到 3D 空間的轉(zhuǎn)換,將多相機的環(huán)視信息融合到 BEV 空間,但預(yù)測、規(guī)劃、控制仍依賴傳統(tǒng)算法。該階段后期出現(xiàn) “BEV 感知 + 預(yù)測一體” 的技術(shù)過渡,進一步提升了環(huán)境理解的連貫性。

3. 軟件 3.0 階段(2023 年至今):端到端技術(shù)成為主流。輸入為圖像,通過神經(jīng)網(wǎng)絡(luò)直接輸出期望行駛軌跡(涵蓋感知、預(yù)測、規(guī)劃),僅控制環(huán)節(jié)保留傳統(tǒng)算法(將軌跡轉(zhuǎn)化為油門、方向盤等執(zhí)行指令)。

4. 未來趨勢:完全端到端(Photon-to-Pedal),即從傳感器光子輸入到踏板控制輸出的全鏈路神經(jīng)網(wǎng)絡(luò)化,目前仍處于探索階段。

(二)1.0 時代:2D 感知的技術(shù)特征與瓶頸

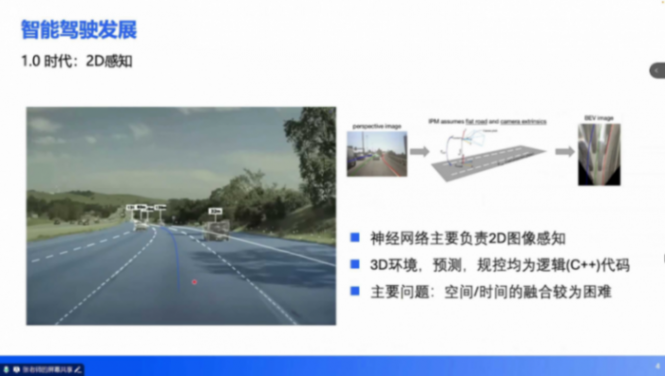

2018-2019 年,深度學習在 2D 視覺任務(wù)中趨于成熟,推動輔助駕駛進入 1.0 時代。該階段的核心技術(shù)是 2D 圖像感知,具體表現(xiàn)為:

技術(shù)實現(xiàn):神經(jīng)網(wǎng)絡(luò)接收 2D 圖像輸入,輸出 2D 檢測框(車輛、行人)、車道線、可行駛區(qū)域分割等信息。為實現(xiàn) 3D 空間行駛,需通過傳統(tǒng)算法(C++)進行后處理:基于逆透視變換(IPM)假設(shè)平坦路面和相機外參,將 2D 信息投影到 3D 空間,再進行預(yù)測與規(guī)控。

核心瓶頸:空間融合困難:環(huán)視多相機(通常 6-7 個)的 2D 信息需手動校準融合,不同視角的誤差累積導致 3D 定位精度不足。時間融合缺失:單幀圖像無法提供動態(tài)信息(如目標速度、加速度),需依賴傳統(tǒng)跟蹤算法補全時序特征,魯棒性較差。數(shù)據(jù)閉環(huán)缺失:感知與規(guī)控的割裂導致難以通過數(shù)據(jù)驅(qū)動優(yōu)化整體性能,需工程師手動修復(fù)邏輯漏洞,迭代效率低下。

(三)2.0 時代:BEV 感知的突破與局限

2021 年,Transformer 架構(gòu)的興起推動輔助駕駛進入 2.0 時代,BEV 感知成為技術(shù)核心:

技術(shù)革新:Transformer 具備強大的空間轉(zhuǎn)換能力,可直接將多相機的 2D 圖像輸入轉(zhuǎn)化為 BEV 空間的 3D 特征,實現(xiàn) “2D→3D” 轉(zhuǎn)換的端到端化。后續(xù)升級版本(2.5 時代)進一步整合預(yù)測任務(wù),引入 Occupancy 占用網(wǎng)絡(luò)(通過體素化表達環(huán)境中所有物體的空間占用狀態(tài)),提升了復(fù)雜場景的理解能力。能力邊界:該階段已能支持高速 NOA(導航輔助駕駛)和部分城區(qū)場景功能,實現(xiàn) “可用但需接管” 的落地效果。

核心局限:規(guī)控輸入受限:神經(jīng)網(wǎng)絡(luò)輸出的是結(jié)構(gòu)化信息(3D 包圍框、車道線矢量等),無法表達復(fù)雜語義(如交通牌文字、交警手勢、異形路口拓撲),導致對施工區(qū)域、多車道紅綠燈等場景的處理能力不足。安全冗余依賴:仍需保留 1.0 時代的傳統(tǒng) AEB(自動緊急制動)算法作為安全備份,兩套系統(tǒng)的協(xié)同邏輯增加了工程復(fù)雜度。

(四)3.0 時代:端到端技術(shù)的能力躍升與挑戰(zhàn)

2023 年起,大模型技術(shù)(如 LLM、VLM)與輔助駕駛深度融合,推動端到端技術(shù)成熟,其核心能力體現(xiàn)在:

通用障礙物理解:可區(qū)分異形障礙物(如輪胎、塑料袋)的物理屬性,而非僅輸出占用網(wǎng)格。例如,面對路中輪胎時會主動繞行,而對塑料袋可能直接通過,決策更貼合實際場景。超視距導航融合:結(jié)合高精度地圖與導航信息,補全傳感器盲區(qū)的道路結(jié)構(gòu)(如隧道出口、環(huán)島內(nèi)部車道),實現(xiàn) “腦補” 式環(huán)境重構(gòu)。復(fù)雜道路結(jié)構(gòu)解析:可理解環(huán)島、多車道對應(yīng)多紅綠燈等復(fù)雜拓撲,例如北京西直門橋、上海延安路高架等場景的車道級路徑規(guī)劃。擬人化軌跡規(guī)劃:通過軌跡點的時間、速度約束間接控制加減速,實現(xiàn)平順繞行、跟車等類人駕駛行為。

技術(shù)挑戰(zhàn):性能波動:端到端模型放大了輔助駕駛的 “上限與下限”。例如,特斯拉 FSD V13 可動態(tài)理解施工人員手勢并安全通行,但也會出現(xiàn)闖紅燈等低級錯誤(依賴單一模型導致的 “幻覺” 問題)。安全冗余矛盾:1.0/2.0 時代的傳統(tǒng)算法需作為安全備份,但當多系統(tǒng)決策沖突時(如 “模型認為無障礙物,傳統(tǒng)算法認為有障礙物”),如何取舍成為工程難題。

二、大模型基礎(chǔ):端到端技術(shù)的底層支撐

端到端輔助駕駛的成熟依賴三類大模型技術(shù):大語言模型(LLM)、視頻生成模型(Diffusion)、仿真渲染技術(shù)(NeRF/3DGS)。三者共同構(gòu)建了 “感知 - 決策 - 驗證” 的全鏈路能力。

(一)大語言模型(LLM):訓練范式的啟發(fā)

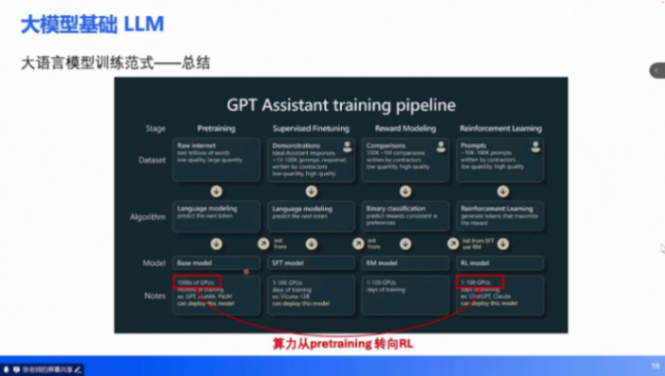

大語言模型的訓練邏輯為端到端輔助駕駛提供了核心方法論,以 DeepSeek-R1 為例,其訓練范式分為四個階段:預(yù)訓練(Pretrain):數(shù)據(jù)準備:收集互聯(lián)網(wǎng)高質(zhì)量文本(維基百科、書籍、新聞等),進行 token 化處理(將文字轉(zhuǎn)化為介于單詞與字母之間的子序列,每個 token 對應(yīng)唯一 ID)。目標任務(wù):Next-Token Prediction(預(yù)測下一個 token),通過學習 token 間的統(tǒng)計關(guān)系理解文本語義。例如,模型能準確預(yù)測偵探小說的兇手時,即具備對前文的理解能力。

監(jiān)督微調(diào)(SFT):數(shù)據(jù)升級:使用人工編寫的高質(zhì)量問答數(shù)據(jù)(如 “如何定義壟斷市場”)替代原始文本,訓練模型從 “續(xù)寫” 轉(zhuǎn)向 “問答”。技術(shù)細節(jié):引入 Chain-of-Thought(CoT,思維鏈)樣例,引導模型通過分步推理提升回答邏輯性。

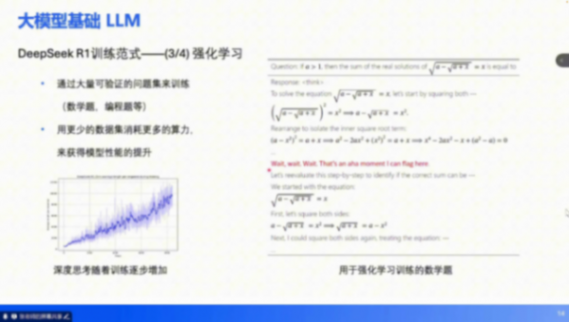

強化學習(RL):數(shù)據(jù)特點:采用可驗證任務(wù)(數(shù)學題、編程題等),通過反饋調(diào)整模型參數(shù)。例如,模型輸出錯誤解題步驟時,通過獎勵函數(shù)懲罰并修正。優(yōu)勢:以更少數(shù)據(jù)消耗更多算力,突破預(yù)訓練階段的 “數(shù)據(jù)瓶頸”,進一步提升模型能力。

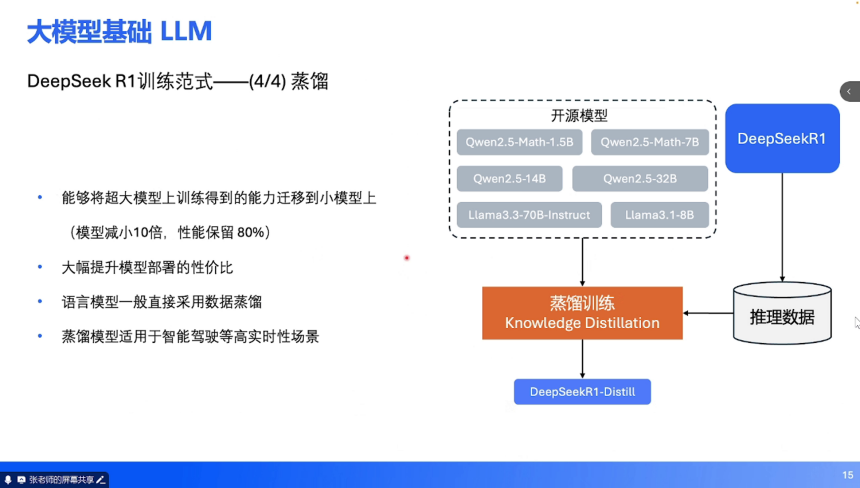

蒸餾(Distillation):目標:將大模型能力遷移到小模型(如參數(shù)減少 10 倍,性能保留 80%),通過大模型生成的推理數(shù)據(jù)訓練小模型,降低部署成本。輔助駕駛適配:車端推理需高實時性,蒸餾技術(shù)可將云端大模型壓縮為車規(guī)級小模型,平衡性能與效率。趨勢:算力分配從預(yù)訓練向強化學習傾斜(傳統(tǒng) 99% 算力用于預(yù)訓練,現(xiàn)逐步轉(zhuǎn)向強化學習),通過精細化調(diào)優(yōu)提升模型可靠性。

(二)視頻生成模型:動態(tài)場景理解的基礎(chǔ)

視頻生成模型(如 Diffusion)通過 Next-Frame Prediction(預(yù)測下一幀圖像)實現(xiàn)對物理世界的動態(tài)理解,其技術(shù)特點包括:

數(shù)據(jù)與任務(wù):輸入為連續(xù)視頻幀(如 10 秒視頻的前 9 秒),輸出預(yù)測的第 10 秒幀。模型需學習光照、運動、物理交互等時空規(guī)律,例如預(yù)測車輛轉(zhuǎn)彎時的車身姿態(tài)變化。

可控生成:結(jié)合文字指令可控制場景參數(shù),如通過 “晴天”“雨夜” 等文本調(diào)整光照、天氣,生成符合約束的駕駛視頻(非真實拍攝,純模型合成)。輔助駕駛應(yīng)用:為仿真系統(tǒng)提供動態(tài)場景生成能力,例如 DriveDreamer 可通過文字控制光照、車道線拓撲,生成多樣化測試場景。

(三)仿真渲染技術(shù):虛擬驗證的核心

仿真技術(shù)是端到端模型訓練與驗證的關(guān)鍵,分為開環(huán)與閉環(huán)兩類:

開環(huán)仿真:本質(zhì):模仿學習(監(jiān)督學習),模型輸入傳感器信號,輸出人類駕駛員的歷史軌跡,不與環(huán)境交互。優(yōu)勢:網(wǎng)絡(luò)結(jié)構(gòu)簡單(如 CNN、Transformer),訓練成本低,適用于初期能力構(gòu)建(如特斯拉早期 FSD、小鵬 XNGP 1.0)。局限:依賴高質(zhì)量數(shù)據(jù)(劣質(zhì)樣本會導致模型 “學壞”),且模型動作不影響環(huán)境(如 “虛擬撞車后場景不變”),無法模擬真實交互。

閉環(huán)仿真:核心特征:自車行為影響所有交通參與者(如 “自車變道會導致旁車減速”),支持多智能體博弈(每個參與者均可加載自車規(guī)控策略,實現(xiàn) “他車即自車” 的自我博弈)。技術(shù)支撐:基于 NeRF(神經(jīng)輻射場)、3DGS(3D 高斯濺射)構(gòu)建真實感渲染引擎,生成與物理世界一致的光照、材質(zhì)效果。優(yōu)勢:可模擬復(fù)雜交通博弈(如無保護左轉(zhuǎn)時與對向車輛的交互),更接近實車環(huán)境,支持強化學習試錯。挑戰(zhàn):系統(tǒng)搭建復(fù)雜(需整合物理引擎、渲染引擎、多智能體決策),虛擬與真實圖像的 “域差距” 仍未完全消除。

三、端到端輔助駕駛:技術(shù)架構(gòu)與訓練范式

端到端輔助駕駛的落地需解決三個核心問題:車端推理的網(wǎng)絡(luò)架構(gòu)、技術(shù)支撐體系、全鏈路訓練范式。

(一)車端推理:網(wǎng)絡(luò)架構(gòu)的實現(xiàn)方式

車端推理需平衡實時性與決策精度,主流架構(gòu)分為三類:

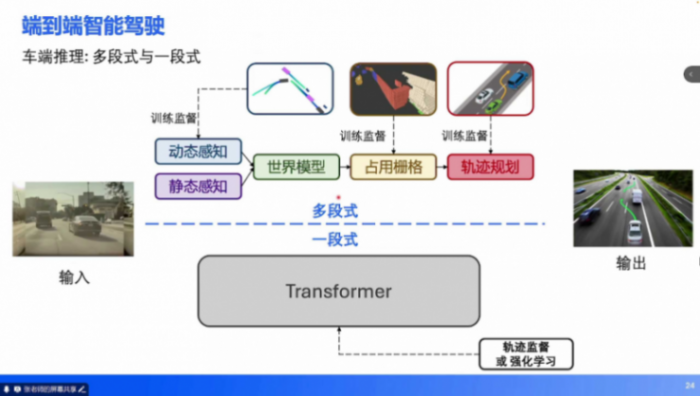

多段式架構(gòu):技術(shù)路徑:繼承 BEV 2.0 時代的模塊化思路,將端到端任務(wù)拆解為 “動態(tài)感知→靜態(tài)感知→世界模型→軌跡規(guī)劃”,每階段輸出均受監(jiān)督(如 3D 檢測框、車道線、占用柵格)。代表案例:小鵬 UniAD 早期版本,通過多任務(wù)監(jiān)督(人類軌跡 + 中間特征)提升訓練穩(wěn)定性,適用于數(shù)據(jù)積累不足的場景。

一段式架構(gòu):技術(shù)路徑:單一神經(jīng)網(wǎng)絡(luò)(如大參數(shù)量 Transformer)直接接收圖像輸入,輸出軌跡(僅受軌跡監(jiān)督或強化學習獎勵),無中間特征輸出。優(yōu)勢:避免多模塊誤差累積,理論上限更高,適用于復(fù)雜場景(如城市擁堵路段)。挑戰(zhàn):訓練難度大(需海量數(shù)據(jù)),易出現(xiàn) “幻覺”(如無中生有障礙物)。

快慢系統(tǒng):設(shè)計理念:借鑒人類 “快思考(直覺)+ 慢思考(推理)” 的認知模式,結(jié)合多段式與一段式優(yōu)勢。快系統(tǒng):多段式架構(gòu),輸出高頻軌跡(幀率 > 10FPS),負責常規(guī)場景(如直線行駛、簡單跟車)。

慢系統(tǒng):一段式架構(gòu)(如 VLM),輸出低頻粗指令(幀率≈1FPS),處理復(fù)雜場景(如施工區(qū)域、交警手勢)。案例:DriveVLM 系統(tǒng)中,慢系統(tǒng)通過自然語言描述場景(“天氣多云,右側(cè)車道有警車停靠”)并生成元動作(“減速并向右避讓”),快系統(tǒng)基于元動作生成精細化軌跡。

(二)技術(shù)支撐:多模態(tài)模型與強化學習

VLM 與 VLA:多模態(tài)理解的核心:

VLM(視覺語言模型):在 LLM 基礎(chǔ)上增加圖像輸入能力,可輸出文字指令(如 “前方紅燈,需停車”),通常作為快慢系統(tǒng)中的慢系統(tǒng)。VLA(視覺 - 語言 - 動作模型):擴展 VLM 的輸出能力,支持直接輸出動作(軌跡點),輸入包含歷史動作序列,適用于一段式端到端架構(gòu)。

強化學習:閉環(huán)場景的優(yōu)化利器:開環(huán) vs 閉環(huán):開環(huán)仿真中,模型模仿人類軌跡但無法影響環(huán)境;閉環(huán)仿真中,模型動作會改變交通參與者行為,支持 “自車與他車的博弈訓練”(如 AlphaZero 的自我對弈)。應(yīng)用價值:通過虛擬試錯(如 “闖紅燈導致碰撞”)修正模型決策,提升極端場景的安全性。例如,模型在仿真中多次嘗試無保護左轉(zhuǎn)后,可學會根據(jù)對向車速動態(tài)調(diào)整起步時機。

(三)訓練范式:全鏈路的迭代邏輯

端到端輔助駕駛的訓練流程與大語言模型一脈相承,分為四個階段:

基座預(yù)訓練:基于視頻生成模型(如 DriveDreamer)進行 Next-Frame Prediction,學習駕駛場景的物理規(guī)律(如車輛運動慣性、光照變化),構(gòu)建世界模型基礎(chǔ)。開環(huán)仿真(模仿學習):在真實采集的駕駛數(shù)據(jù)中訓練,讓模型模仿人類軌跡(如人類在環(huán)島的轉(zhuǎn)向時機、跟車距離),快速積累基礎(chǔ)駕駛能力。

閉環(huán)仿真(強化學習):在虛擬環(huán)境中通過自我博弈優(yōu)化模型,例如讓 10 輛搭載同一模型的虛擬車在復(fù)雜路口交互,通過獎勵函數(shù)(如 “通行效率高 + 無碰撞”)強化優(yōu)質(zhì)決策。

實車部署與反饋:初期以 “影子模式” 運行(模型輸出與人類駕駛對比,不直接控制車輛),收集接管數(shù)據(jù)(如人類糾正模型錯誤的場景)作為負樣本。將實車數(shù)據(jù)回灌至閉環(huán)仿真,迭代優(yōu)化模型,形成 “虛擬訓練→實車驗證→數(shù)據(jù)回傳→再訓練” 的閉環(huán)。

端到端輔助駕駛是大模型技術(shù)在具身智能領(lǐng)域的典型應(yīng)用,其發(fā)展路徑印證了 “從分立式到一體化”“從規(guī)則驅(qū)動到數(shù)據(jù)驅(qū)動” 的技術(shù)規(guī)律。目前,行業(yè)仍面臨三大挑戰(zhàn):模型幻覺的抑制、虛擬與真實世界的域?qū)R、多安全系統(tǒng)的協(xié)同決策。但隨著大模型能力的提升與仿真技術(shù)的成熟,完全端到端(Photon-to-Pedal)的實現(xiàn)已不再遙遠。正如 Andrej Karpathy 所言,未來的輔助駕駛系統(tǒng)或?qū)⑹?“一個融合多模態(tài)輸入、遵循交通規(guī)則的超級智能體”,而這一目標的達成,需要 “仰望星空” 的技術(shù)愿景與 “腳踏實地” 的工程落地相結(jié)合。